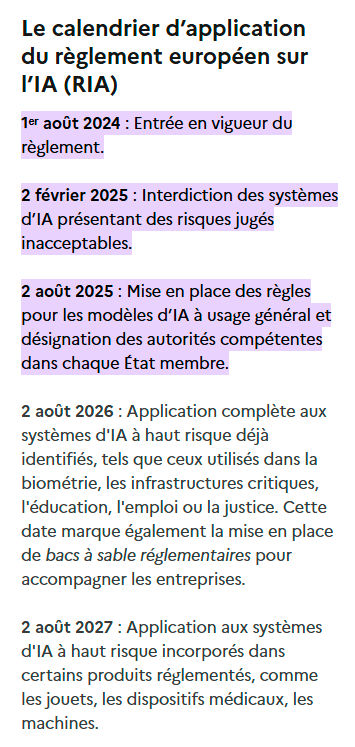

Depuis le 2 août 2025, les premières obligations contraignantes de l’AI Act européen sont entrées en vigueur, ciblant directement les fournisseurs de modèles d’intelligence artificielle à usage général. Si Google, Microsoft et Meta sont en première ligne de cette réglementation historique, les répercussions se font déjà sentir sur l’ensemble de l’écosystème français de l’IA, des startups aux grandes entreprises.

Les géants de la tech face à leurs nouvelles obligations

Le 2 août 2025 marque un tournant pour l’industrie mondiale de l’intelligence artificielle. Pour la première fois, les fournisseurs de modèles d’IA générative comme ChatGPT, Gemini ou Grok doivent se plier à des obligations juridiques contraignantes sur le territoire européen. Ces nouvelles règles, issues de l’AI Act, imposent une transparence sans précédent sur le fonctionnement de ces systèmes qui transforment nos économies.

Désormais, chaque fournisseur de modèle d’IA à usage général doit produire une documentation technique détaillée expliquant les processus d’entraînement de ses algorithmes. Plus délicat encore, ils doivent publier un résumé des données utilisées pour former leurs modèles, une exigence qui touche au cœur de leur avantage concurrentiel. Enfin, ils doivent mettre en place des politiques strictes de respect du droit d’auteur, permettant aux créateurs de contenu de vérifier que leurs œuvres ont été utilisées légalement.

Google entre coopération et résistance

La position de Google illustre parfaitement les tensions que suscite cette nouvelle réglementation. D’un côté, le géant de Mountain View a signé le code de bonnes pratiques rédigé par la Commission européenne, témoignant d’une volonté apparente de dialogue constructif. De l’autre, l’entreprise a publiquement exprimé ses inquiétudes, estimant que cette réglementation risquait de « freiner le déploiement de l’IA en Europe ».

Cette ambivalence s’explique par les enjeux considérables que représentent ces nouvelles obligations pour Gemini, le modèle d’IA de Google. L’entreprise doit désormais révéler des informations qu’elle considérait jusqu’alors comme des secrets industriels : les sources de données utilisées pour l’entraînement, les méthodes de filtrage et de nettoyage de ces données, ou encore les mesures prises pour détecter et corriger les biais algorithmiques.

Google a signé le code de bonnes pratiques, y compris le chapitre sur le droit d’auteur. Mais son application peut se révéler problématique pour la Firme de Mountain View

Microsoft dans une approche plus pragmatique

Microsoft semble avoir adopté une stratégie plus conciliante face à l’AI Act. Forte de ses investissements massifs dans OpenAI et de l’intégration de GPT dans son écosystème via Copilot et Bing Chat, l’entreprise paraît mieux préparée à ces nouvelles exigences. Cette approche s’explique peut-être par son expérience européenne : Microsoft collabore depuis des années avec les régulateurs du continent sur les questions de données et de vie privée.

L’entreprise de Redmond doit néanmoins faire face aux mêmes défis que ses concurrents. Tous les modèles GPT intégrés dans ses services doivent désormais respecter les obligations de transparence, notamment sur les données d’entraînement et les politiques de propriété intellectuelle. Cette contrainte pourrait influencer les futurs développements de l’IA Microsoft, qui devra concevoir ses systèmes en tenant compte de ces exigences européennes dès la phase de conception.

Meta assume sa position de résistance

L’attitude de Meta tranche avec celle de ses concurrents. Le groupe de Mark Zuckerberg a purement et simplement refusé de signer le code de bonnes pratiques européen. Joel Kaplan, responsable des affaires publiques de Meta, dénonce un texte contenant trop d’incertitudes et critique une approche qu’il juge trop contraignante pour l’innovation.

Cette position de force s’explique en partie par la stratégie de Meta sur le marché européen de l’IA générative. Contrairement à Google ou Microsoft, l’entreprise mise davantage sur des modèles open source comme Llama, ce qui pourrait lui offrir plus de flexibilité face aux obligations européennes. Toutefois, ce refus de coopération ne dispense pas Meta des obligations légales de l’AI Act, qui reste juridiquement contraignant avec des sanctions pouvant atteindre 7% du chiffre d’affaires mondial.

L’onde de choc sur l’écosystème français

Ces nouvelles obligations imposées aux géants américains créent des répercussions en cascade sur l’ensemble de l’écosystème français de l’intelligence artificielle. Les entreprises françaises qui utilisent des services basés sur ChatGPT, Gemini ou d’autres modèles d’IA générative se retrouvent indirectement concernées par ces changements réglementaires.

Une transparence forcée qui profite aux utilisateurs

La documentation technique que doivent désormais fournir les géants de l’IA bénéficie directement aux entreprises françaises qui intègrent ces technologies dans leurs activités. Pour la première fois, elles peuvent connaître précisément les capacités et les limites des systèmes qu’elles utilisent, information cruciale pour évaluer les risques et optimiser leur utilisation.

Cette transparence nouvelle permet également aux entreprises françaises de mieux comprendre les biais potentiels de ces systèmes et d’adapter leurs pratiques en conséquence. Un cabinet de recrutement utilisant l’IA pour filtrer des candidatures peut désormais accéder aux informations sur les données d’entraînement et les mesures anti-discriminatoires mises en place par le fournisseur.

Des répercussions sur les coûts et l’innovation

L’obligation pour les fournisseurs d’IA de respecter le droit d’auteur européen pourrait également modifier l’équation économique pour les entreprises françaises. Si les géants de la tech doivent désormais rémunérer les créateurs de contenu pour l’utilisation de leurs œuvres dans l’entraînement des modèles, ces coûts supplémentaires pourraient se répercuter sur les tarifs des services proposés aux entreprises.

Paradoxalement, cette contrainte pourrait aussi stimuler l’innovation en Europe. Face aux nouvelles obligations, certaines entreprises françaises pourraient être tentées de développer leurs propres solutions d’IA ou de se tourner vers des alternatives européennes comme Mistral AI, qui pourrait bénéficier d’un avantage concurrentiel en tant qu’acteur local déjà familier avec le cadre réglementaire européen.

L’incertitude créée par le retard administratif français

Cette transformation de l’écosystème se déroule dans un contexte d’incertitude particulier en France. Contrairement à l’échéance du 2 août fixée par l’AI Act, la France n’a toujours pas désigné officiellement son autorité nationale compétente pour surveiller l’application de la réglementation. Cette situation place les entreprises françaises dans une zone grise juridique, ne sachant pas exactement vers quelle autorité se tourner en cas de questions ou de problèmes.

Actuellement, les entreprises doivent jongler entre plusieurs interlocuteurs : la CNIL pour les aspects liés aux données personnelles, la Direction générale des entreprises (DGE) pour l’accompagnement économique, et les autorités sectorielles existantes selon leur domaine d’activité. Cette fragmentation complique la mise en conformité et peut créer des interprétations divergentes d’un même texte réglementaire.

Ce qui change concrètement pour les entreprises françaises

Au-delà de ces répercussions indirectes, les entreprises françaises font face à leurs propres obligations depuis l’entrée en vigueur progressive de l’AI Act. Certaines règles sont déjà en application depuis février 2025, d’autres depuis le 2 août, créant un paysage réglementaire en constante évolution.

Les interdictions déjà en vigueur

Depuis le 2 février 2025, plusieurs pratiques d’intelligence artificielle sont formellement interdites sur le territoire français. L’utilisation de systèmes de notation sociale par les autorités publiques est désormais prohibée, mettant fin à toute velléité de créer un « crédit social » à la chinoise en Europe. Les entreprises ne peuvent plus exploiter les vulnérabilités de populations fragiles – enfants, personnes âgées, personnes en situation de handicap – pour influencer leur comportement de manière nuisible.

Plus délicat pour certains secteurs, l’identification biométrique à distance en temps réel dans les espaces publics est également interdite, sauf exceptions très restrictives pour les forces de l’ordre. Cette interdiction concerne directement les entreprises de sécurité privée, les centres commerciaux ou les organisateurs d’événements qui utilisaient la reconnaissance faciale pour identifier leurs visiteurs.

Les obligations de transparence depuis le 2 août

Depuis le 2 août 2025, toute entreprise française utilisant des systèmes d’IA générative doit respecter de nouvelles obligations de transparence. Lorsqu’un client ou un utilisateur interagit avec un chatbot ou un système de génération de contenu, il doit être clairement informé qu’il communique avec une intelligence artificielle et non avec un humain.

Cette obligation s’étend à l’étiquetage de tous les contenus générés par IA. Une agence de communication utilisant des outils comme Midjourney pour créer des visuels ou ChatGPT pour rédiger des textes doit désormais mentionner explicitement l’origine artificielle de ces productions. Cette exigence transforme déjà les pratiques dans les secteurs de la création, du marketing et de la communication.

Les entreprises doivent également documenter précisément les capacités et limites des systèmes d’IA qu’elles déploient, information qui doit être accessible à leurs utilisateurs et collaborateurs. Un outil de traduction automatique doit ainsi préciser ses langues supportées, ses limites dans certains domaines techniques, et les précautions d’usage recommandées.

L’obligation de formation du personnel

L’article 4 de l’AI Act impose une obligation souvent négligée : la formation du personnel utilisant des systèmes d’intelligence artificielle. Cette exigence concerne potentiellement des millions de salariés français, des commerciaux utilisant des CRM enrichis d’IA aux journalistes expérimentant avec des outils de rédaction automatisée.

Cette formation doit couvrir non seulement l’utilisation pratique des outils, mais aussi la compréhension de leurs limites, les risques associés et les bonnes pratiques éthiques. Pour beaucoup d’entreprises françaises, cette obligation représente un défi organisationnel et budgétaire considérable, nécessitant de repenser leurs programmes de formation continue.

Vers une montée en puissance progressive

L’AI Act prévoit une application progressive de ses dispositions jusqu’en 2027. Les systèmes d’IA à haut risque, utilisés notamment dans les secteurs de la santé, de l’éducation ou de l’emploi, devront respecter des exigences renforcées à partir d’août 2026. Ces systèmes devront faire l’objet d’évaluations de conformité, être accompagnés d’une supervision humaine permanente, et respecter des standards techniques stricts en matière de précision et de sécurité.

Cette montée en puissance laisse du temps aux entreprises françaises pour s’adapter, mais elle exige dès maintenant une anticipation stratégique. Les organisations qui utilisent ou développent des systèmes d’IA dans ces secteurs sensibles doivent commencer à préparer leur mise en conformité pour éviter de se retrouver dans l’urgence en 2026.

Une transformation en profondeur

L’entrée en vigueur des premières obligations de l’AI Act marque le début d’une transformation profonde de l’écosystème européen de l’intelligence artificielle. Si les géants américains de la tech sont contraints d’adapter leurs pratiques à la réglementation européenne, cette évolution crée aussi de nouvelles opportunités pour les acteurs français et européens.

L’incertitude créée par le retard de désignation des autorités françaises complique certes la mise en œuvre de ces nouvelles règles, mais elle n’efface pas l’obligation pour les entreprises de s’y conformer. Dans ce contexte mouvant, les organisations qui anticipent ces changements et intègrent dès maintenant les exigences de l’AI Act dans leur stratégie IA prendront une longueur d’avance décisive sur leurs concurrents.

Car au-delà des contraintes immédiates, l’AI Act dessine les contours d’une intelligence artificielle plus transparente, plus éthique et plus respectueuse des droits fondamentaux. Pour les entreprises françaises, cette évolution représente l’opportunité de construire une approche de l’IA qui concilie innovation technologique et valeurs européennes, positionnement qui pourrait devenir un avantage concurrentiel durable sur la scène internationale.

Ce contenu vous a plu ?

Inscrivez-vous gratuitement à notre newsletter et recevez chaque semaine l’actualité du SEO directement dans votre boîte email. Vous pouvez vous désabonner à tout moment !