Une question qui divise la communauté scientifique

Quand ChatGPT a déferlé sur le monde fin 2022, une question inattendue a commencé à agiter les laboratoires de recherche : ces nouveaux modèles d’intelligence artificielle, appelés « grands modèles de langage » (ou LLMs pour Large Language Models), peuvent-ils jouer aux échecs ?

La question peut sembler anecdotique, mais elle cache en réalité un enjeu scientifique majeur : ces IA, conçues pour comprendre et générer du texte, sont-elles capables d’un véritable raisonnement stratégique, ou ne font-elles que recycler intelligemment ce qu’elles ont mémorisé ?

Les résultats des dernières études scientifiques, publiées entre 2024 et 2025, dessinent un tableau pour le moins contrasté.

Des prouesses techniques impressionnantes… en apparence

Le miracle GPT-3.5-turbo-instruct

L’histoire commence en septembre 2023, quand Nicholas Carlini, chercheur en sécurité IA, découvre presque par hasard que GPT-3.5-turbo-instruct – une variante moins connue de ChatGPT – peut jouer aux échecs à un niveau surprenant.

Mais attention : ce modèle ne « voit » pas un échiquier. Il reçoit uniquement l’historique textuel de la partie, écrit dans une notation spécialisée appelée PGN (Portable Game Notation). Imaginez devoir jouer aux échecs en lisant uniquement une liste de coups comme « 1.e4 e5 2.Nf3 Nc6… » sans jamais voir le plateau.

Malgré cette contrainte, le modèle atteint un niveau de jeu impressionnant, équivalent à celui d’un joueur humain compétent. Une performance qui a surpris jusqu’aux chercheurs d’OpenAI.

ChessLLM : quand l’IA atteint le niveau professionnel

En 2025, une équipe de recherche chinoise a franchi un cap supplémentaire avec « ChessLLM ». Leur approche : entraîner spécifiquement un modèle sur 10 millions de parties d’échecs, en utilisant une notation encore plus compacte appelée FEN (Forsyth-Edwards Notation).

Le FEN, qu’est-ce que c’est ? Imaginez pouvoir décrire entièrement une position d’échecs en une seule ligne de texte, comme une « photo » instantanée du plateau. C’est exactement ce que fait cette notation : « rnbqkbnr/pppppppp/8/8/8/8/PPPPPPPP/RNBQKBNR » décrit la position de départ d’une partie.

Résultat : ChessLLM atteint un classement Elo de 1788 – soit le niveau d’un joueur de club expérimenté, voire d’un maître FIDE dans certaines fédérations. Une performance remarquable pour une IA qui n’a jamais « vu » un échiquier de sa vie.

Le record absolu : 2895 points Elo

Mais le record revient à une équipe de Google DeepMind qui, début 2024, a entraîné des transformers (l’architecture des LLMs) sur un dataset gigantesque : 15 milliards de positions annotées par Stockfish 16, le meilleur moteur d’échecs actuel.

Leur modèle le plus performant atteint 2895 points Elo sur la plateforme Lichess – soit le niveau grand maître international. Pour contextualiser : Magnus Carlsen, l’ancien champion du monde, culmine autour de 2830 points.

La douche froide : quand la réalité rattrape l’enthousiasme

L’étude qui fait mal

Mais en janvier 2025, une étude indépendante vient brutalement rappeler à la réalité. Un chercheur teste méthodiquement 13 modèles d’IA conversationnels – GPT-4o, Claude 3.5 Sonnet, Gemini 1.5 Pro et autres stars du moment – dans des parties complètes contre un simple algorithme jouant au hasard.

Le résultat est sans appel : aucun des 13 modèles ne gagne une seule partie. Pas une. Ces IA, pourtant capables de disserter brillamment sur la stratégie échiquéenne, s’avèrent incapables de conduire une partie cohérente du début à la fin.

Le paradoxe de la mémorisation

Comment expliquer un tel écart ? Les chercheurs de Stanford et du MIT apportent une explication troublante dans leur étude de juillet 2025 : ces modèles ne « comprennent » pas les échecs au sens où nous l’entendons.

Ils sont ce que les scientifiques appellent des « prédicteurs de séquences » : des systèmes extraordinairement doués pour identifier des patterns dans d’énormes quantités de données et prédire la suite logique d’une séquence. Quand GPT-3.5 joue « e5 » après « 1.e4 », il ne « réfléchit » pas tactiquement – il reproduit le pattern le plus fréquent dans les millions de parties qu’il a ingérées.

Les règles ? Quelles règles ?

L’analyse est encore plus gênante. Une équipe de recherche découvre que même les modèles spécialement entraînés aux échecs peinent à maîtriser les règles fondamentales du jeu.

Exemple concret : ils peuvent proposer des coups géniaux dans des positions complexes (par reconnaissance de patterns) tout en étant incapables d’appliquer correctement des règles basiques comme le roque ou la prise « en passant » dans des situations inédites.

C’est comme si vous aviez mémorisé par cœur les 1000 plus belles parties de Kasparov sans jamais vraiment apprendre à jouer.

L’entraînement par renforcement : l’espoir déçu

RLVR : quand l’IA apprend de ses erreurs

Face à ces limitations, les chercheurs ont testé une approche plus sophistiquée : l’apprentissage par renforcement avec récompenses vérifiables (RLVR pour Reinforcement Learning with Verifiable Rewards).

Le principe : au lieu de simplement montrer des « bonnes » parties au modèle, on le fait jouer et on évalue chaque coup avec un score de qualité. L’IA apprend ainsi de ses erreurs, comme un joueur humain qui analyse ses défaites.

Cette méthode a révolutionné les mathématiques en IA – elle a permis aux modèles de résoudre des problèmes olympiques inédits. L’espoir était grand pour les échecs.

Le plafond de verre

Mais une étude de 2025 documente un phénomène troublant : malgré cet entraînement sophistiqué, tous les modèles testés (Qwen2.5, Llama3.1) « plafonnent » rapidement à des niveaux bien inférieurs aux experts humains.

Plus troublant encore : même les modèles o1 d’OpenAI, spécialement conçus pour le raisonnement et capables de résoudre des problèmes de physique de niveau doctorat, ne parviennent pas à dépasser ce plafond aux échecs.

Pourquoi cette différence entre math et échecs ?

La nature du problème

Les chercheurs avancent une hypothèse fascinante : contrairement aux mathématiques, les échecs nécessitent un type de raisonnement très spécifique que les LLMs actuels ne maîtrisent pas.

En mathématiques, même un problème complexe suit des règles logiques universelles que l’IA peut extrapoler de ses connaissances générales. Aux échecs, chaque position est unique et nécessite une évaluation stratégique en temps réel, prenant en compte les intentions de l’adversaire – ce qu’on appelle le « raisonnement stratégique multi-agents ».

Le problème de la représentation interne

Une découverte particulièrement troublante émerge des études : les LLMs semblent incapables de construire une représentation interne stable de l’échiquier.

Une analogie : imaginez essayer de jouer aux échecs en ayant une image floue et changeante du plateau dans votre tête. Même si vous connaissez parfaitement la théorie, vos décisions seront erratiques.

C’est exactement ce qui semble se passer : les modèles peuvent réciter brillamment l’ouverture espagnole ou la défense sicilienne, mais leur « modèle mental » de la position actuelle reste fragile et imprécis.

Le rôle surprenant du langage

Quand expliquer aide à raisonner

Un résultat inattendu émerge des recherches : les performances des LLMs aux échecs s’améliorent significativement quand on leur demande d’expliquer leur raisonnement en langage naturel.

L’équipe qui a créé le dataset MATE (1 million de positions annotées par des experts) découvre que les modèles entraînés avec des explications linguistiques – « ce coup développe le cavalier tout en attaquant le centre » – surpassent nettement ceux entraînés uniquement sur les coups.

Cette découverte questionne une idée reçue : contrairement à ce que pensent certains chercheurs, le langage ne serait pas juste un « outil de communication » pour les IA, mais pourrait être intrinsèquement lié à leurs capacités de raisonnement.

Vers une conclusion nuancée

Les IA jouent-elles vraiment aux échecs ?

La réponse dépend entièrement de ce qu’on entend par « jouer ».

Si on définit « jouer aux échecs » comme « produire des coups légaux et parfois brillants », alors oui, certains LLMs spécialement entraînés en sont capables, et même à un niveau impressionnant.

Mais si on définit « jouer aux échecs » comme « comprendre les règles, construire une stratégie cohérente et s’adapter intelligemment à l’adversaire », alors la réponse est clairement non.

L’intelligence artificielle face au mur de la complexité

Cette recherche sur les échecs révèle quelque chose de plus profond sur l’état actuel de l’IA. Nos LLMs sont des machines à patterns extraordinairement sophistiquées, capables de performances éblouissantes dans leur domaine de prédilection : le langage et les connaissances textuelles.

Mais ils semblent butter sur certains types de raisonnement qui nous paraissent naturels : la représentation spatiale, la planification stratégique à long terme, la modélisation des intentions d’autrui.

Implications pour l’avenir

Ces limitations ne sont pas nécessairement permanentes. Plusieurs pistes émergent déjà :

- L’intégration multimodale : combiner texte et représentation visuelle de l’échiquier

- Les architectures hybrides : associer LLMs et algorithmes de recherche classiques

- L’amélioration des données d’entraînement : inclure plus de parties commentées et expliquées

Mais elles nous rappellent une vérité fondamentale : l’intelligence artificielle actuelle, malgré ses prouesses spectaculaires, reste encore très différente de l’intelligence humaine.

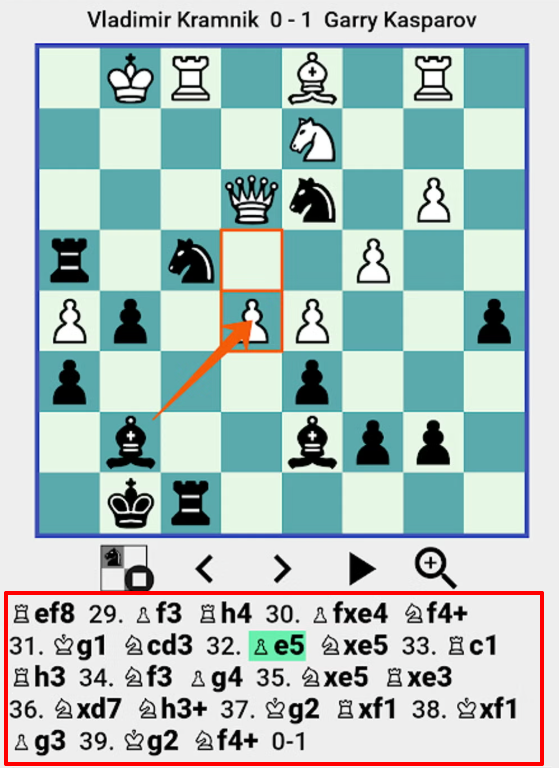

Ah au fait, Magnus Carlsen a battu Chat GPT à plate couture il y’a quelques semaines

Et sa dernière partie il y’a quelques jours, organisée par Chess.com

Bibliographie

Succès techniques :

- Amortized Planning with Large-Scale Transformers: A Case Study on Chess (2024) – Google DeepMind

- Complete Chess Games Enable LLM Become A Chess Master (2025) – Zhang et al.

- Explore the Reasoning Capability of LLMs in the Chess Testbed (2024) – Wang et al.

Limitations et échecs :

- Can Large Language Models Develop Strategic Reasoning? Post-training Insights from Learning Chess (2025) – Étude Stanford/MIT

- Can LLMs Play Chess? I’ve Tested 13 Models (2025) – Étude empirique comparative

- Can Large Language Models Learn to play Chess? (2024) – Fine-tuning Gemma 2B

Analyses et découvertes initiales

- Playing chess with large language models (2023) – Nicholas Carlini, découverte GPT-3.5-turbo-instruct

- GitHub – carlini/chess-llm – Code source et implémentation

- GTBench: Uncovering the Strategic Reasoning Limitations of LLMs via Game-Theoretic Evaluations (2024) – Benchmark de raisonnement stratégique

Ce contenu vous a plu ?

Inscrivez-vous gratuitement à notre newsletter et recevez chaque semaine l’actualité du SEO directement dans votre boîte email. Vous pouvez vous désabonner à tout moment !