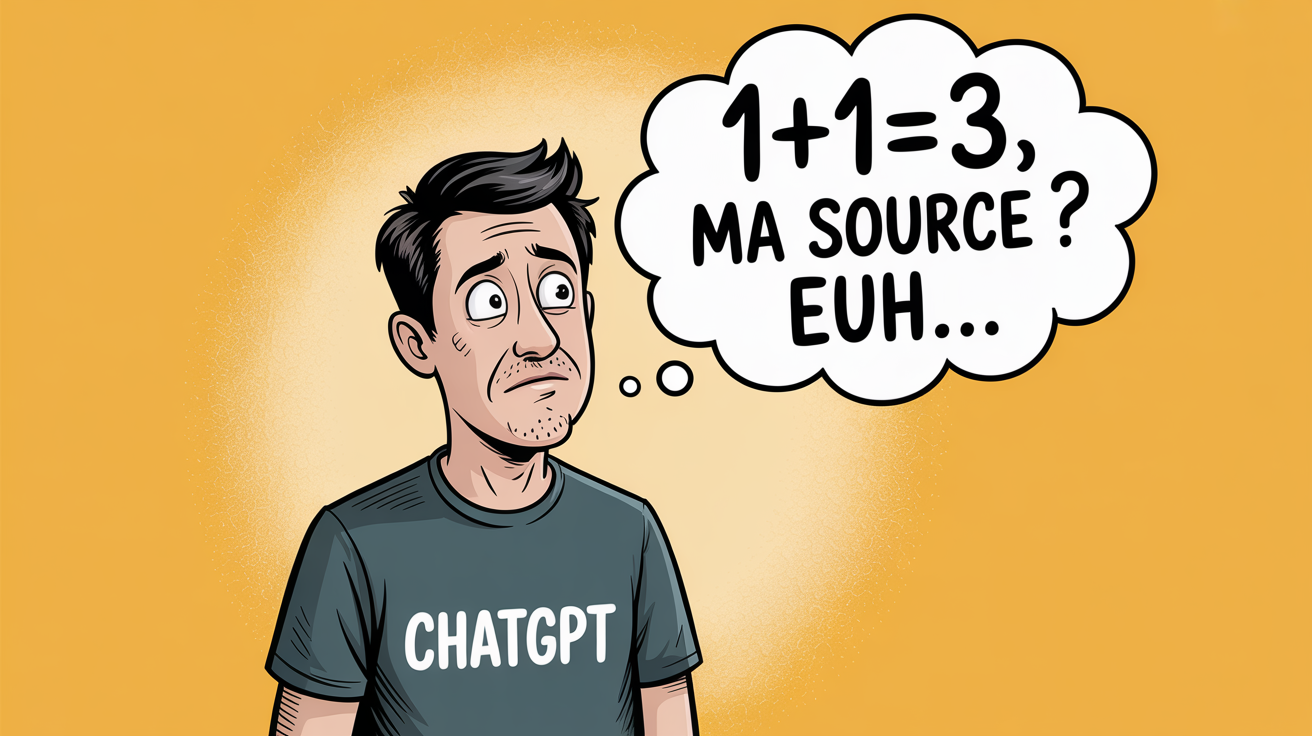

aussi mauvaises pour « sourcer » l’origine de leurs informations ?

Beaucoup ont soupçonné les pionniers de l’IA générative de vouloir « disrupter » les modèles habituels pour conserver 100% du trafic sur leur site.

D’autres, plus adeptes de la théorie du complot, les ont soupçonné de « cacher » les sources, pour masquer tous les défauts de leurs réponses :

- réemploi de sources non fiables ou sans réelle autorité

- reprise de fake news

- ou présence d’erreurs factuelles dans la réponse, alors que la source contenait la bonne information.

En réalité, la raison de cette incapacité à « sourcer » son information vient d’une raison bien plus profonde. C’est lié à une caractéristique fondamentale des LLMs.

En réalité, un modèle de fondation, ou un Large Language Model, est construit en analysant une masse énorme de documents et de fichiers digitaux, pour élaborer un système qui crée des contenus qui leur ressemblent, mais sans conserver la mémoire exacte de l’emplacement des informations qui ont servi à entraîner le modèle.

Stocker la source ne fait pas du tout partie du processus.

La suite sur le blog de Neper Consulting :