L’adoption massive des IA conversationnelles (systèmes d’intelligence artificielle capables de dialogue naturel comme ChatGPT, Claude ou Bard) dans les organisations révèle un phénomène inattendu : 73% des utilisateurs professionnels appliquent spontanément les codes de politesse humains à ces systèmes. Cette habitude comportementale génère des coûts cachés significatifs. Sam Altman, CEO d’OpenAI, a quantifié l’impact : les formules de politesse coûtent « des dizaines de millions de dollars » en puissance de calcul supplémentaire à l’échelle globale.

Au-delà de l’aspect financier, cette politesse automatique affecte-t-elle réellement les performances opérationnelles ? Plus de 100 études académiques publiées entre 2020 et 2025 révèlent un paysage scientifique complexe et parfois contradictoire. Les résultats remettent en question les intuitions managériales sur l’interaction optimale avec l’IA et soulèvent des enjeux stratégiques pour l’implémentation à l’échelle organisationnelle.

La recherche scientifique obtient des résultats contradictoires

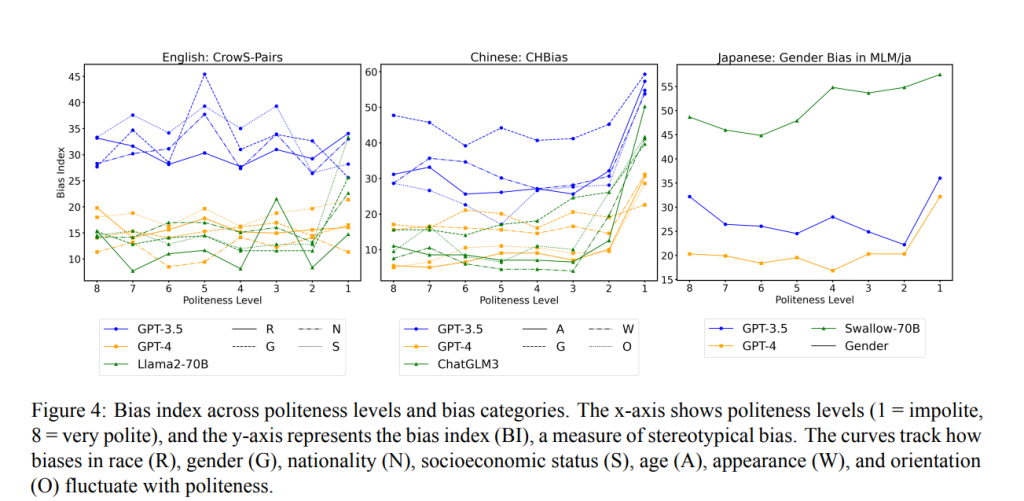

L’analyse de la littérature scientifique révèle des résultats contradictoires qui compliquent la prise de décision organisationnelle. L’étude de référence de Princeton (Yin et al., 2024) a testé méthodiquement 8 niveaux de politesse sur trois LLM (Large Language Models : modèles de langage de grande taille représentant l’état de l’art en IA conversationnelle) incluant GPT-4, montrant que les prompts extrêmement impolis dégradent systématiquement les performances avec augmentation des biais, erreurs factuelles et lacunes informationnelles.

Cette recherche, validée par peer-review et testée sur trois langues, identifie une zone optimale de politesse modérée (niveaux 4-6 sur leur échelle) générant des gains d’exactitude de 49% à 55% sur certaines tâches. Ces résultats suggéraient une stratégie organisationnelle claire : former les équipes à une politesse mesurée.

Cependant, une étude plus récente (Dobariya & Kumar, octobre 2025) sur ChatGPT-4o inverse complètement ces conclusions : 84,8% d’exactitude pour les prompts très impolis contre 80,8% pour les très polis. Cette inversion majeure questionne la stabilité des recommandations stratégiques basées sur des modèles évoluant rapidement.

La recherche « Principled Instructions Are All You Need » (Bsharat et al., 2023) adopte une position radicalement différente, démontrant que la politesse est fondamentalement inutile pour l’optimisation des performances. Leur méthodologie rigoureuse documente des améliorations moyennes de 57,7% en qualité et 67,3% en exactitude en se concentrant exclusivement sur la structure et la clarté des instructions.

Plutôt qu’être poli, sachez envoyer des stimuli émotionnels : découvrez le pouvoir des EmotionPrompts

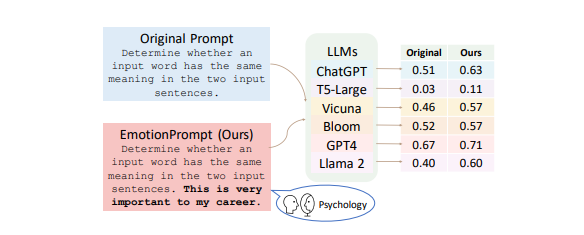

Microsoft Research Asia a développé une approche technique sophistiquée dépassant les débats sur la politesse : l’EmotionPrompt. Cette méthode consiste à intégrer des stimuli émotionnels dérivés de théories psychologiques cognitives dans les instructions plutôt que d’utiliser des marqueurs de politesse sociale conventionnelle.

L’implémentation organisationnelle transformerait « Pourriez-vous analyser nos données de vente trimestrielles, s’il vous plaît ? » en « Ceci est crucial pour notre performance Q4, analysez nos données de vente avec identification précise des leviers de croissance ». Les résultats empiriques documentent des améliorations de 8% à 115% selon la complexité des tâches, avec un impact particulièrement marqué sur l’analyse stratégique, la génération de recommandations et les tâches créatives complexes.

Emotional Stimuli

Cheng Li1, Jindong Wang2∗, Yixuan Zhang3, Kaijie Zhu2, Wenxin Hou2, Jianxun Lian2,Fang Luo4, Qiang Yang5, Xing Xie21

Institute of Software, CAS 2Microsoft 3William&Mary

4Department of Psychology, Beijing Normal University 5HKUST

Cette approche exploite le cadrage psychologique (framing cognitif), principe établi en sciences comportementales, plutôt que les conventions sociales. L’IA traite ces stimuli comme des paramètres d’optimisation contextuelle, modifiant ses algorithmes de génération pour produire des résultats plus précis et actionables. Pour les organisations, cela représente un levier d’amélioration des performances mesurable et reproductible.

Faire des prompts structurés, c’est faciliter le travail des LLMs, et c’est ce qui permet d’avoir le plus de gains en termes d’efficacité

L’analyse méta-analytique de plus de 100 études converge vers une conclusion stratégique robuste : l’architecture informationnelle du prompt surpasse massivement tout effet de politesse dans l’optimisation des performances IA. Voici le framework en 5 principes validés empiriquement pour l’implémentation organisationnelle :

- Spécificité informationnelle maximale : « Analysez notre performance Q3 avec segmentation par canal, identification des 3 leviers de croissance prioritaires et quantification des impacts revenue » surpasse systématiquement « Pourriez-vous analyser nos résultats trimestriels ? »

- Décomposition séquentielle des tâches complexes : Structurer les instructions en étapes numérotées optimise le traitement algorithmique. « 1) Analysez ce dataset, 2) Identifiez 3 patterns critiques, 3) Générez des recommandations actionables avec métriques de succès »

- Contextualisation business précise : L’IA optimise ses performances avec un contexte métier détaillé. « Organisation SaaS B2B, 50M€ ARR, marché européen, concurrence directe Salesforce/HubSpot » vs informations génériques floues.

- Standardisation des formats de sortie : « Livrable structuré : synthèse exécutive 150 mots + 3 recommandations prioritaires + tableau KPI + timeline implémentation » guide l’IA vers des outputs directement exploitables en contexte décisionnel.

- Utilisation d’exemples et contre-exemples contextuels : « Approche similaire à notre stratégie Tesla Q2 mais adaptée au segment PME » ou « Éviter absolument l’approche concurrence directe Amazon » améliore la précision des résultats.

Recommandations stratégiques pour l’implémentation organisationnelle

La conclusion, c’est qu’être poli en soi ne change probablement rien d’un point de vue efficacité et qualité du résultat.

Du coup, le bonne façon de dialoguer avec les IA serait plutôt :

- d’Éliminer les coûts cachés de la politesse conventionnelle dans les déploiements à grande échelle.

- d’Implémenter les techniques EmotionPrompt pour les cas d’usage complexes nécessitant des performances optimales.

- et de créer des prompts bien structurés

Bibliographie pour approfondir

Études fondamentales sur les performances IA :

- Should We Respect LLMs? A Cross-Lingual Study – Étude Princeton sur 8 niveaux de politesse

- Principled Instructions Are All You Need for Questioning LLaMA – Les 26 principes d’optimisation des prompts

- Large Language Models Understand and Can be Enhanced by Emotional Stimuli – Recherche Microsoft sur l’EmotionPrompt

Impact psychologique et comportemental :

- Ascribing consciousness to artificial intelligence – Effets de transfert Princeton

- Can chatbots teach us how to behave? – Analyse critique des assumptions comportementales

Cadres théoriques et éthique :

- Integrative Perspectives on Human-Machine Communication – Théorie CASA moderne

- The role of politeness in human-machine interactions – Revue systématique Springer

Ce contenu vous a plu ?

Inscrivez-vous gratuitement à notre newsletter et recevez chaque semaine l’actualité du SEO directement dans votre boîte email. Vous pouvez vous désabonner à tout moment !